I film e i telefilm sono sempre stati il luogo ideale dove poter far viaggiare la fantasia dei registi, dei telespettatori, ma anche il campo ideale dove è possibile far incontrare la scienza e la fantascienza. Negli anni Settanta ed Ottanta nelle pellicole cinematografiche e nelle fiction di fantascienza le porte si aprivano da sole o, nei casi di basi segrete e stanze nascoste, si utilizzavano sofisticati sistemi che permettevano di aprirle attraverso il riconoscimento facciale o con le impronte digitali. Le fiction odierne si sono spinte oltre. Ad esempio, grazie all’Intelligenza Artificiale e a tecniche biometriche si raccolgono illegalmente dati in tutto il globo dagli impianti di sorveglianza pubblici e privati, con l’obiettivo di prevedere gli eventi e individuare i criminali.

Ma a che punto è la ricerca rispetto al futuro descritto nelle serie televisive? I ricercatori sono riusciti a far diventare scienza la fantascienza dello schermo e il riconoscimento facciale una tecnologia che oggi usiamo quotidianamente. Possiamo bloccare o sbloccare con uno sguardo gli smartphone, le auto riconoscono quando il guidatore è stanco e non è più in grado di guidare.

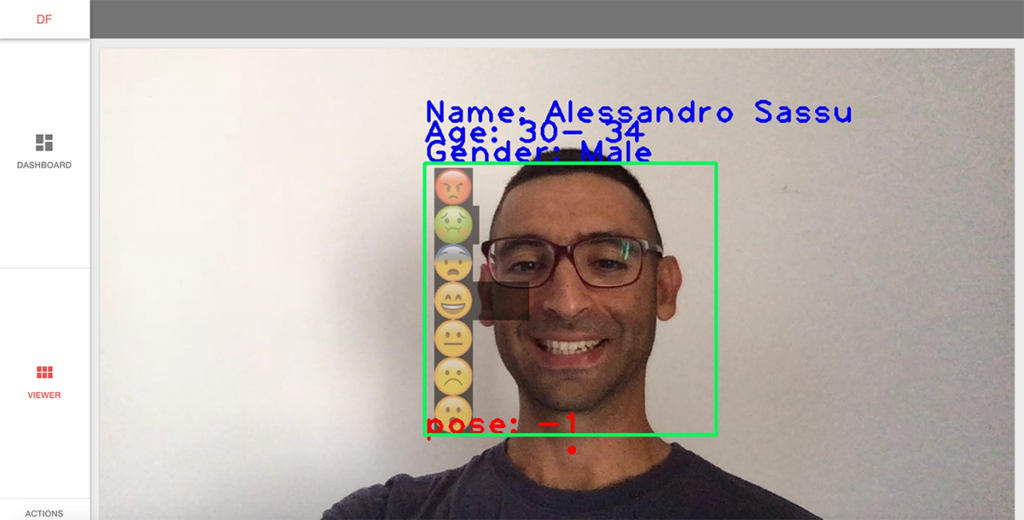

Al centro di ricerca, sviluppo e studi superiori in Sardegna, Crs4, con sede presso il Parco tecnologico di Pula, si studia il futuro immaginato nelle serie televisive. Il gruppo di ricerca Content Technologies & Information Management, guidato da Maurizio Agelli, da anni lavora ad una serie di applicazioni che permettono di riconoscere, all’interno di una immagine o di un video, un volto riuscendo a fornire anche altre tipologie d’informazione, come l’età, il genere o l’espressione facciale, in tempo reale. Il progetto si chiama DEEP, acronimo di “Data Enrichment for Engaging People”, sviluppato in collaborazione con la società Alkemy SpA, con l’obiettivo di realizzare una piattaforma di analisi e previsione in grado di trattare in tempo reale grossi flussi di contenuti testuali e visuali, provenienti da molteplici contesti ad alta frequenza di produzione.

“Sicurezza, sorveglianza del territorio ma anche comprensione delle interazioni dei visitatori di un museo di fronte ad un’opera d’arte – spiega Maurizio Agelli – sono soltanto alcuni degli sviluppi che si possono immaginare. Le tecnologie che abbiamo sviluppato partono dal concetto fondamentale di estrarre informazioni dalle immagini e di come sia possibile interpretarle. Quindi non sono solo informazioni che si limitano a descrivere l’immagine, ma proprio dati che delineano la scena nell’immagine e che riconoscono gli oggetti”.

Analisi che si possono certamente fare “a mano”, a posteriori, sia su immagini che su video ma che sono estremamente onerose in termini di tempo e di persone. “Se pensiamo ad archivi di migliaia di fotografie e immagini video da analizzare – prosegue il ricercatore – possiamo soltanto immaginare il tempo necessario per completarlo, senza contare che questa tipologia di lavoro non è possibile farla in tempo reale. Basti pensare a quei casi in cui una videocamera riprende una scena 24 su 24 e dove non è possibile fare un lavoro a posteriori perché è necessario prendere decisioni immediate. Come nel caso del settore della sicurezza inteso sia nel senso di security, per verificare che non entrino una certa tipologia di persone all’interno di un evento o di un’area, o semplicemente intesa come safety ossia l’accorgersi che determinati movimenti di folla possono diventare pericolosi se non sono rilevati in tempo reale e se non si pongono in essere nell’immediato azioni specifiche”.

Il progetto Deep si articola in diversi ambiti: telecomunicazioni, turismo/beni culturali e new media. “Noi ora siamo concentrati sul settore del turismo e dei beni culturali – prosegue il ricercatore – dove stiamo sviluppando due tipologie di prototipi. Il primo è finalizzato a monitorare le reazioni dei visitatori di fronte ad un determinato artefatto visuale, ossia capire quante persone si fermano, cosa guardano, per quanto tempo, quali sono le caratteristiche di queste persone e quindi identificare dal volto la loro età, il genere, capire se effettivamente stanno guardando l’opera o stanno guardando altrove. Inoltre, il sistema riesce anche a leggere le espressioni facciali classificate in sette tipologie: felicità, disgusto, paura, sorpresa, tristezza, rabbia e neutrale. Il secondo è finalizzato a monitorare le persone presenti in grandi spazi, ad esempio contando le persone presenti in una piazza e identificandone i flussi alle varie ore del giorno. L’obiettivo è quello di cercare di comprendere, ed eventualmente, indirizzare, l’esperienza culturale del visitatore tarandola sulle sue esigenze”.

Queste ricerche hanno suscitato un forte interesse anche in altri ambiti come in quello commerciale e nel marketing, dove da sempre, si vuole capire chi sono le persone che acquistano, conoscere le loro caratteristiche e soprattutto gli interessi in real time.

Gli studi non si esauriscono qui e si sta già pensando a future applicazioni come ad esempio riuscire a tracciare e monitorare dove una persona, o un flusso di persone, si sposta all’interno di una camera o di uno spazio aperto ma anche avere la possibilità di fare stime precise. Tutte queste informazioni verrebbero poi proiettate in modelli e mappe 3D in modo da vedere in real time cosa sta succedendo e “prevederlo”. Ma queste tecnologie portano con sé anche delle criticità legate ad aspetti legali e soprattutto di privacy senza contare poi, nel caso di autonomia d’azione, di etica.